爬虫scrapy框架及案例:带Cookies请求/下载中间件/UA/Proxy代理添加(P15-P16)

P15 带Cookies请求、随机 ua,代理

源码分析

- 自己定义

start_requests方法 - 带

cookies请求,或者登录后的数据 - 在 settings.py 里有对应的设置

COOKIE_DEBUG=True

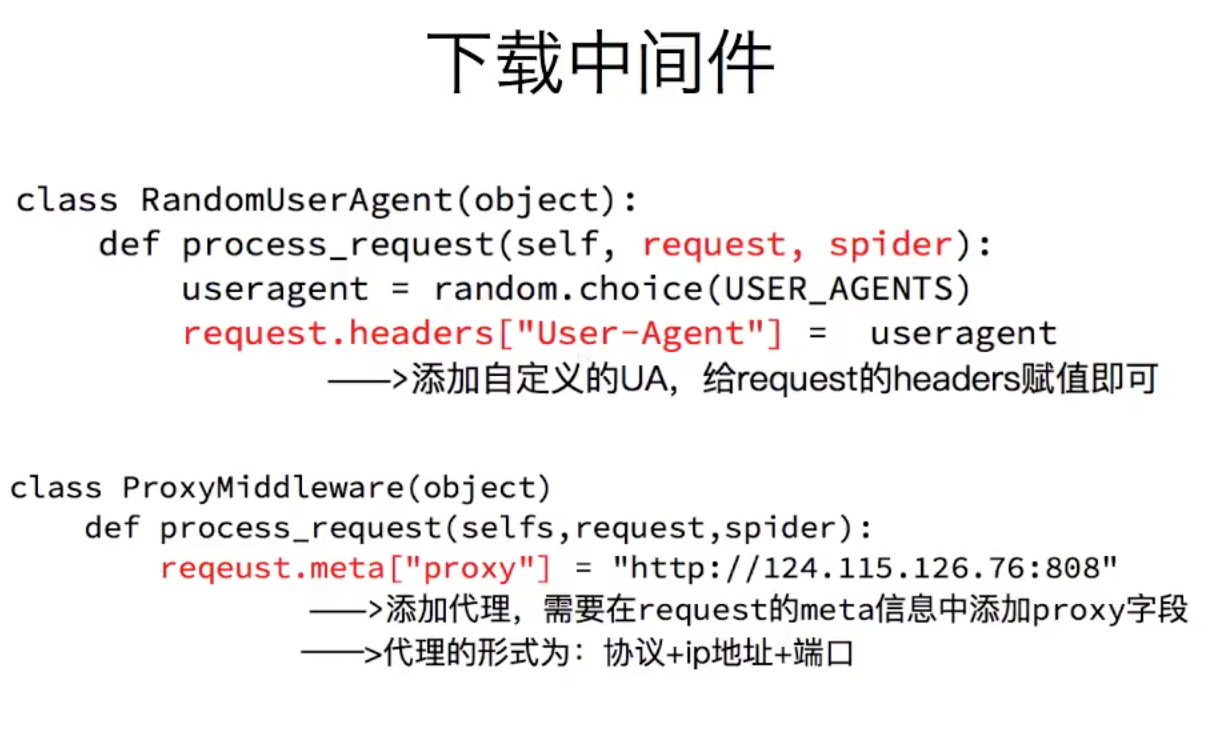

下载中间件

import random

class RandomUaMiddleware:

def process_request(self, request, spider):

ua = random.choice(spider.settings.get("UA_LIST")

request.headers["User-Agent"] = ua

return request参考

https://www.bilibili.com/video/BV1jt411Q7PD?p=16&spm_id_from=pageDriver